自己回帰モデル

自己回帰モデル(じこかいきモデル、英: autoregressive model)は時点 t におけるモデル出力が時点 t 以前のモデル出力に依存する確率過程である。ARモデルとも呼ばれる。

自己回帰モデルは、例えば自然科学や経済学において、時間について変動する過程を描写している。(古典的な)自己回帰モデルは実現値となる変数がその変数の過去の値と確率項(確率、つまりその値を完全には予測できない項)に線形に依存している。ゆえに自己回帰モデルは一種の確率差分方程式の形状を取る。

自己回帰モデルはより一般的な時系列の自己回帰移動平均モデル(ARMAモデル)の特別なケースである。また、一つ以上の確率差分方程式からなるベクトル自己回帰モデル(VARモデル)の特別ケースでもある。推計統計学・機械学習における生成モデルとしても自己回帰モデルは表現でき、古典的な(線形)自己回帰生成モデルを拡張した非線形自己回帰生成モデルも盛んに研究されている。

定義

[編集]という記法はオーダー p の自己回帰モデルを意味している。AR(p) モデルは以下のように定義される。

ここで はモデルのパラメーターであり、 は定数項、 はホワイトノイズである。この式は後退オペレーター B を用いることで以下のような同値である表現で書き表すことが出来る。

よって、左辺の総和を移項し多項式表現を用いれば、

と表せる。ゆえに自己回帰モデルは、ホワイトノイズを入力値とする、全ての極における無限インパルス応答の出力値として見なすことも出来る。

自己回帰モデルが弱定常であるためにはいくつかのパラメーター制約が必要になる。例えば、 であるAR(1) モデルで表現される過程は定常ではない。より一般的に、AR(p) モデルが弱定常であるためには、多項式 の根が単位円の内側になくてはならない。つまり全ての根 が を満たさなくてはならない。

ショックの異時点間における影響

[編集]自己回帰モデルにおいて、一時点でのショックは将来の更新変数の値に恒久的に影響を与える。例えば、AR(1) モデル を考えてみよう。t=1 時点での の値がゼロでなければ、 の量だけ に影響がある。この時、 から見た についてのAR方程式により、 は の量だけ に影響を与える。さらに、 から見た についてのAR方程式により、 は の量だけ に影響を与える。これを繰り返すことで の効果は永久に波及することが分かる。しかしながら、過程が定常過程ならば、この効果は極限において0となる。

全てのショックが、それが起こった時点から X に恒久的に影響を与えるため、任意の与えられた Xt の値は過去に起こったショック全てから影響を受ける。これは自己回帰方程式

(ここで定数項は変数が平均からの逸脱として測定されると仮定することで無視できる)が以下のように書き直せることからもまた分かる。

右辺における多項式の除算が可能なのであれば、 に適用される後退オペレーターによる多項式は無限次元のオーダーを持つ。つまり、 のラグ値が方程式の右辺において無限個現れる。

特性多項式

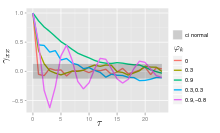

[編集]AR(p) 過程の自己相関関数は以下のように表すことが出来る[1]。

ここで は以下の多項式の根である。

ここで B は後退オペレーターであり、 は自己回帰を定義する関数、 は自己回帰における係数である。

AR(p) 過程の自己相関関数は指数減衰する部分の和となっている。

- 全ての実数根は指数減衰する自己相関関数の構成要素として寄与する。

- 同様にすべての複素数の共役根の組は指数的に減衰する循環として寄与する。

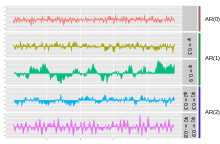

AR(p) 過程のグラフ

[編集]

最も単純なARモデルは AR(0) であり、項の間に依存関係がない。誤差/イノベーション/ノイズ項のみが過程の出力に寄与し、ゆえに図で示されているように AR(0) はホワイトノイズに対応する。

の値が正である AR(1) 過程について、その過程の以前の項とノイズ項のみが出力に寄与する。もし が0に近ければ、その過程は依然としてホワイトノイズのように見える。しかし、 が1に近いならば、出力はノイズに比べて現在の項に大きな影響を受ける。結果として出力の"スムージング"もしくは和分が起こり、ローパスフィルタと似たものとなる。

AR(2) 過程について、以前の二つの項とノイズ項が出力に寄与する。 と が共に正ならば、出力はノイズの高周波数領域が減衰するローパスフィルタに似通ったものとなる。もし が正である一方で が負であれば、過程はその項の間で符号が変わりやすくなる。出力は循環的となる。これは方向におけるエッジ検出もしくは変化検出と結びつけることが出来る。

例: AR(1) 過程

[編集]AR(1) 過程は以下で与えられる。

ここで は平均0のホワイトノイズ過程でありその分散は定数 である(注記: の下につく添え字をなくしている)。もし ならば、この確率過程は弱定常である。というのもこの過程はホワイトノイズを入力とする定常フィルターの出力として得られるからである(もし ならば の分散は無限大となり、ゆえに弱定常ではなくなる)。結果として、 を仮定すれば、平均 は全ての t の値について同じとなる。もし平均を と書くのであれば、以下の式

より次の式

が成り立ち、ゆえに以下が得られる。

特に、 ならば、平均は0である。

分散は以下のように定まる。

ここで は の標準偏差である。これは以下の式、

と上の量は安定な不動点となることから示される。

自己共分散は以下で与えられる。

自己共分散関数は の減衰時間(または時定数)で減衰していくことが分かる[これを見るために と書く。ここで は に依存しない。この時、 であり、指数減衰法則 と一致する]。

スペクトル密度とは自己共分散関数のフーリエ変換である。離散時間の場合、フーリエ変換は離散時間フーリエ変換に対応する。

この表現は の離散的性質により周期的となり、それは分母におけるコサイン項によって明らかとなっている。もしサンプリング時間 () が減衰時間 () より非常に小さいと仮定するならば、 の連続体近似を用いることが出来る。

これにより、コーシー分布(ローレンツ型プロファイル)のスペクトル密度が得られる。

ここで は減衰時間 に対応した角周波数である。

についての を定義式にまず代入することで、 の別表現が得られる。これを N 回繰り返せば

となる。N を無限大まで発散させれば、 は0に近づき、

となる。 は の核で畳み込まれたホワイトノイズに定数の平均を足したものとなることが分かる。もしホワイトノイズ がガウス過程ならば もまたガウス過程である。他の場合として、中心極限定理により が1に近づけば は正規分布に近似的に近づくことが分かる。

AR(1) 過程の解析的な平均と差分の形式

[編集]AR(1) 過程は連続時間におけるオルンシュタイン=ウーレンベック過程の離散時間のアナロジーである。ゆえに AR(1) モデルの性質を理解するために同様の形式に変換することが時として有用になる。この形式において AR(1) モデルは以下で与えられる。

ここで であり はモデルの平均である。これを の式に当てはめ についての系列に展開することで次が示される。

- , and

- .

最大ラグの選択

[編集]AR(p) 過程の偏自己相関はラグが p + 1 より大きい時にゼロとなり、結果として適切な最大ラグはそのラグより大きいラグでの偏自己相関が全てゼロになるものである。

ARパラメーターの計算

[編集]ARモデルの係数の推定には多数の方法があり、例えば最小二乗法の手続きや、もしくは(ユール–ウォーカー方程式(英: Yule–Walker equation)を通した)モーメント法がある。

AR(p) モデルは以下の方程式で与えられる。

この方程式はパラメーター i = 1, ..., p に基いている。これらのパラメーターと過程の共分散関数の間には直接的な対応が存在し、その対応は(共分散から得られる)自己相関関数からパラメーターを決定する為に裏返すことができる。これはユール–ウォーカー方程式を用いて行われる。

ユール–ウォーカー方程式

[編集]ユール–ウォーカー方程式は、ウドニー・ユールとギルバート・ウォーカーにちなんで名づけられたもので[2][3]、以下の方程式からなる[4]。

ここで m = 0, ..., p であり、p + 1 個の方程式からなる。さらに は Xt の自己共分散関数、 は入力ホワイトノイズの標準偏差、 はクロネッカーのデルタである。

各方程式の最後の部分がゼロとならないのは m = 0 の時に限られるので、この方程式は m > 0 の方程式を行列形式に表すことで解くことが出来る。よって次の方程式が得られる。

これは全ての について解くことが出来る。残りの m = 0 についての方程式は

となり、一度 の値を知ってしまえば、この方程式を について解くことが出来る。

他の定式化として自己相関についてのものがある。ARパラメーターは自己相関 の最初の p + 1 個の要素で決定する。完全な自己相関関数はこの時、再帰的な計算によって導出できる[4][5]。

幾つかの低い次数の AR(p) 過程についての例は

- p=1

- ゆえに

- p=2

- AR(2) 過程のユール–ウォーカー方程式は

- であることを思い出せば、

- 第一の方程式を用いることで となり、

- 第二の方程式を用いることで となる。

- AR(2) 過程のユール–ウォーカー方程式は

ARパラメーターの推定

[編集]上の方程式(ユール–ウォーカー方程式)は、理論的な共分散を推定値に置き換えることで、 AR(p) モデルのパラメーターを推定する為にいくつかの方法を提供する[6]。下記のような方法が考えられる。

- 自己共分散もしくは自己相関の推定。便利な推定法を用いて自己共分散もしくは自己相関の項のそれぞれを分割して推定したものとする。推定の方法は多様であり、どれを選択するかは推定のスキームが持つ性質に影響を与える。例えば、ある方法では分散の負の推定量が生じうる。

- Xt の予測値を同じ系列の過去の p 個の値として基礎づける最小二乗予測問題を構築する上での最小二乗回帰問題としての定式化。これは前方予測スキームとして考えられる。この問題についての正規方程式は同じラグで現れる自己共分散を少し違った推定値で置き換えたユール–ウォーカー方程式の行列形式の近似と対応するように見える。

- 最小二乗予測問題の拡張形式としての定式化。ここで二つの予測方程式のセットを一つの推定スキームと単一の正規方程式に結合する。一つのセットは前方予測方程式のセットとなっており、もう片方は対応する後方予測方程式のセットとなっている。これはARモデルの後退表現と関連している。

- ここで予測値 Xt は同じ系列の p 個の将来の値に基づいている。このARパラメーターの推定方法はジョン・バーグ(John P. Burg)[7] によるものでバーグの方法(英: the Burg method)と呼ばれる[8]。バーグや後続の研修者はこの特別な推定値を"最大エントロピー推定量"と呼ぶが[9]、この背後にある理論は推定パラメータ―のどのようなセットについても適用できる。前進予測方程式のみを用いた推定スキームと比べると、異なる自己共分散の推定値が得られ、推定量は異なる安定性の性質を持つ。バーグ推定量は特に最大エントロピースペクトル推定と関連している[10]。

他の考えられる方法として最尤法がある。異なる二つの最尤法が利用できる。一つは(大体は最小二乗スキームによる前方予測と同じだが)考慮する尤度関数を系列における当初の p 此の値を所与とした系列の後の値の条件つき分布に対応させるものである。もう一つは考慮する尤度関数を観測された系列の全ての値の無条件の同時分布に対応させるものである。これらの方法の結果における本質的な違いは観測系列が短い、もしくは過程が非定常に近い時に現れる。

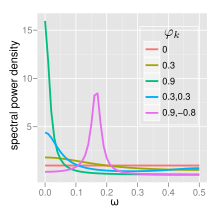

スペクトル

[編集]

ノイズ分散が である AR(p) 過程のパワースペクトル密度は以下のようになる[11][5]。

AR(0)

[編集]ホワイトノイズ (AR(0)) については以下のようになる。

AR(1)

[編集]AR(1) については以下のようになる。

- もし ならば、スペクトルは f = 0 において単峰で、レッドノイズと呼ばれる。 が1に近ければ低周波においてパワーが強くなる。つまり時間のラグが大きくなる。これはローパスフィルタであり、フルスペクトル光に適用された時、赤の波長を除いてすべてがフィルタリングされる。

- もし ならば、スペクトルは f = 0 において最小値を取り、ブルーノイズと呼ばれる。これはハイパスフィルタのように振る舞い、青の波長を除いてすべてがフィルタリングされる。

AR(2)

[編集]AR(2) 過程は特性方程式の根に依存する3つのグループに分割される。

- の時、過程は複素共役根のペアを一つ持ち、中周波でピークを作る。

そうでなければ実数根を持ち、

- の時、 で頂点を持つホワイトノイズに対するローパスフィルタのように振る舞い、

- の時、 で頂点を持つホワイトノイズに対するハイパスフィルタのように振る舞う。

根が単位円の外側にある時、この過程は定常である。 根が単位円の内側にある、もしくは同じことだが係数が三角形 の内部にある時、安定である。 完全なパワースペクトル密度関数は以下のように表される。

統計パッケージにおける実装

[編集]- R, stats パッケージに ar 関数が含まれている[12]。

- MATLAB, Econometric Toolbox[13] と System Identification Toolbox[14] に自己回帰モデルが含まれている[15]。

- MATLABとOctave: TSA toolbox に単一変数、複数変数、適応自己回帰モデルについてのいくつかの推定関数が含まれている[16]。

n 期先予測

[編集]自己回帰

のパラメーターが一度推定されてしまえば、この自己回帰は将来の任意の時点での予測に用いることが出来る。まず、t をデータが使えない最初の時点とする。既知の値Xt-i for i=1, ..., p を自己回帰方程式に代入し、誤差項 をゼロと置く(なぜならば Xt をその条件つき期待値と一致させるように予測し、観測されない誤差項の期待値は0であるから)ことで予測ができる。自己回帰方程式の出力は最初のデータが観測されない時点についての予測となる。次に、t をデータが使えない 次の 時点とする。もう一度自己回帰方程式を予測を作るために使うことができる。ただし一つ異なる点がある。X の今予測している時点より一期前の値は未知である。よってその期待値、つまり前の予測ステップでの予測値を代わりに用いる。この時、将来の時点において同じ手続きが用いられ、p 回の予測の後に、全ての p 個の右辺の値が事前のステップによる予測値となるまで、予測方程式の右辺における予測値を用いる。

この方法で得られた予測値について四つの不確実性のソースがある。(1) 自己回帰モデルが正しいモデルかどうかという不確実性、(2) 自己回帰方程式の右辺においてラグ値として用いられる予測値の正しさについての不確実性、(3) 自己回帰係数の真の値についての不確実性、(4) 予測機関における誤差項 の値についての不確実性である。最後の三つは定量化可能で n ステップ後の予測についての信頼区間として与えられる。右辺の変数についての推定値が増えるため信頼区間は n が増えれば広くなる。

予測の質の評価

[編集]自己回帰モデルの予測性能は、クロス・バリデーションが行われるならば、推定の後に即座に評価できる。この方法においては、最初の方の利用可能なデータはパラメーターの推定の為に用いられ、データセットにおける後の方のデータはアウトオブサンプルのテストとして残しておく。他には、パラメーター推定が行われた後にしばらくしたあと、より多くのデータが利用可能になり予測性能を新しいデータを使うことで評価できる。

どちらのケースも、評価可能な予測性能には2つの側面がある。1期先予測の性能と n 期先予測の性能である。1期先予測の性能について、推定パラメーターは予測を行った期以前の全ての期における X の観測値と共に自己回帰方程式が用いられ、方程式の出力は1期先予測となる。この手続きはアウトオブサンプルの観測値についての予測を得るために用いられる。n 期先予測の質を評価する為には、予測を得るために前の節での予測手続きが用いられる。

予測値のセットと対応する様々な期間の X の本当の値のセットが与えられたとして一般的な評価のテクニックは平均二乗予測誤差を用いることである。他の尺度もまた用いられる。

ここで測定された予測の正しさをどのように解釈するのかという問題が持ち上がる。例えば平均二乗予測誤差が"高い"(悪い)もしくは"低い"(良い)とはどういう事なのだろうか。比較の上で二つのポイントがある。第一に他のモデルの仮定もしくは推定手法の下で推定された代替モデルの予測の正しさは比較目的に使用できる。第二にアウトオブサンプルの正確さの尺度は十分に前のデータを用いることが出来るならば、つまり最初の p 個のデータポイントを落として p 期以前のデータを使わないならば(パラメーター推定に用いられた)インサンプルのデータポイントでの同じ尺度と比較できる。モデルはインサンプルのデータポイントに出来るだけ適合するように特定化されて推定されるので、普通はアウトオブサンプルの予測性能はインサンプルの予測性能より悪い。しかし予測の質がアウトオブサンプルで(正確には定義できないが)"そう悪くない"のであれば、予測値は十分なパフォーマンスを見せていると言える。

統計モデル・生成モデルとしての表現

[編集]上記のように自己回帰モデルは、決定論的/deterministicな線形変換に、確率的/probabilisticなブレ(確率項)が線形に追加されるモデルである。別の表現として、自己回帰モデルは統計モデル(生成モデル)で表すことができる[17]。

自己回帰モデル AR(n) を考えるとし、因果関係を持つ時点 t から時刻 t-n までの値の組を

とする。Xn の確率分布すなわち xt ~ xt-nの同時確率 pAR(n) は

であり、条件付き確率の定義を用いる(確率の連鎖律)と

となる(条件付確率分布の積、因子分解の積)。モデルのn次自己回帰性(== 過去方向にn次までしか依存しない)より xt-n はそれ単体で分布が定まる。

p(xt-k|xt-k-1, xt-k-2, ..., xt-n)を考えると(線形変換・ガウス確率項)ARモデルは確率項がガウス分布に従い、その平均値統計量は決定論的な線形変換で決まるため、

であるといえる。xt-k-1より過去の系列の情報はすべてxt-k-1の実現値として集約されている。

以上をまとめると、n次自己回帰モデルは統計モデル/生成モデルとして以下のように定式化できる。

・・・(1)

確率分布が計算可能なため、データ(標本)が与えられた際の母集団パラメータを最尤推定を用いて推定することができる。また生成モデルであるため、モデルに従う系列の生成(例: 現時刻までのデータに基づいた将来系列の生成)が可能である。もし音声を時系列とみなせば音声合成をおこなうことが可能になる。

非線形自己回帰生成モデル

[編集]古典的な自己回帰モデルは系列要素間の関係を線形と仮定してきたが、近年では非線形自己回帰モデルも提唱されている。人工ニューラルネットワークと深層学習の発達により発達した自己回帰生成ネットワーク(Autoregressive Generative Networks)がその代表例である。

自己回帰モデルを生成モデルとして表現したとき、xt はそれ以前の値(xt-1, xt-2 ,...)で条件づけられた確率分布からサンプリングされる。線形の自己回帰モデルではガウス分布の平均値が前要素の線形変換になるとモデル化するが、この条件は緩和することができる。上記の(1)式、すなわち過去値に条件づけられた確率分布関数を非線形関数を含む任意の関数とすることでこれが達成できる。

確率分布を人工ニューラルネットワークによって表現することで非線形性を導入し深層学習によって実データに基づく分布の推定/学習(最尤推定など)をおこなったものが自己回帰生成ネットワークである[17]。DeepMind社が開発したWaveNet[18]はAutoregressive Generative Networksの代表例であり、音声波形を系列とみなして自己回帰モデル化・学習することにより、人の声と区別がつかない音声の合成に成功している。

バリエーション

[編集]非線形自己回帰生成モデルは制約を緩めた分、いくつかの変種(モデル上の違い)がある。

確率分布

[編集]- カテゴリカル分布(ソフトマックス関数)

サンプリング

[編集]- ランダムサンプリング

- 最大確率(ArgMax)

- ビームサーチ

統計的推論(学習)・最適化

[編集]非線形自己回帰生成モデルの難点の1つは、非線形性からくるパラメータ推定の難しさにある。統計的推論には最尤推定がしばしば用いられるが、古典的な(線形)ARモデルと比較してパラメータ推定の難易度が高い。

teacher forcing

[編集]teacher forcing は自己回帰入力に教師信号を用いる、自己回帰モデル学習技法の1つである[19]。自己回帰モデルは系列長が長くなるほど誤差を蓄積する特性をもつ。teacher forcingは学習時に教師信号を自己回帰入力することで、誤差のない(理想的な)入力に基づいた学習を可能にする。

exposure bias

[編集]teacher forcingで学習したモデルに関して、推論時に与えられる自己回帰入力は文字通り「自己回帰」であり、学習時に得られるようなノイズの無い理想信号とは限らない。ゆえに学習が不十分なモデルでは推論時の自己回帰入力が学習時と乖離してしまうため、その振る舞いは予期できないものになる。この問題を exposure bias という。

脚注

[編集]- ^ Zetterberg, Lars H. (1969), “Estimation of parameters for a linear difference equation with application to EEG analysis”, Mathematical Biosciences 5 (3): 227--275, doi:10.1016/0025-5564(69)90044-3, ISSN 0025-5564

- ^ Yule, G. Udny (1927), “On a Method of Investigating Periodicities in Disturbed Series, with Special Reference to Wolfer's Sunspot Numbers”, Philosophical Transactions of the Royal Society of London, Ser. A 226: 267–298

- ^ Walker, Gilbert (1931), “On Periodicity in Series of Related Terms”, Proceedings of the Royal Society of London, Ser. A 131: 518–532

- ^ a b Hamilton & (1994), p. 59

- ^ a b Von Storch, H.; F. W Zwiers (2001). Statistical analysis in climate research. Cambridge Univ Pr. ISBN 0-521-01230-9[要ページ番号]

- ^ Hamilton & (1994), Chapter 3 and 5

- ^ Burg, John P. (1968), “A new analysis technique for time series data”, in D. G. Childers, Modern Spectrum Analysis, NATO Advanced Study Institute of Signal Processing with emphasis on Underwater Acoustics, New York: IEEE Press

- ^ Brockwell, Peter J.; Dahlhaus, Rainer; Trindade, A. Alexandre (2005). “Modified Burg Algorithms for Multivariate Subset Autoregression”. Statistica Sinica 15: 197–213.

- ^ Burg, John P. (1967), “Maximum Entropy Spectral Analysis”, Proceedings of the 37th Meeting of the Society of Exploration Geophysicists (Oklahoma: Oklahoma City)

- ^ Bos, R.; De Waele, S.; Broersen, P. M. T. (2002). “Autoregressive spectral estimation by application of the burg algorithm to irregularly sampled data”. IEEE Transactions on Instrumentation and Measurement 51 (6): 1289. doi:10.1109/TIM.2002.808031.

- ^ Hamilton & (1994), p. 155

- ^ "Fit Autoregressive Models to Time Series" (in R)

- ^ Econometrics Toolbox Overview

- ^ System Identification Toolbox overview

- ^ "Autoregressive modeling in MATLAB"

- ^ "Time Series Analysis toolbox for Matlab and Octave"

- ^ a b 亀岡 (2019) 深層生成モデルを用いた音声音響信号処理. http://www.kecl.ntt.co.jp/people/kameoka.hirokazu/publications/Kameoka2019SICE03_published.pdf

- ^ The model is fully probabilistic and autoregressive, with the predictive distribution for each audio sample conditioned on all previous ones... Aaron van den Oord, et al.. (2016) WaveNet: A Generative Model for Raw Audio

- ^ "to replace the actual output of a unit by the teacher signal in subsequent computation of the behavior of the network, whenever such a value exists. We call this technique 'teacher forcing.' " Williams & Zipser. (1989). A Learning Algorithm for Continually Running Fully Recurrent Neural Networks. doi: 10.1162/neco.1989.1.2.270

参考文献

[編集]- Mills, Terence C. (1990). Time Series Techniques for Economists. Cambridge University Press

- Percival, Donald B.; Walden, Andrew T. (1993). Spectral Analysis for Physical Applications. Cambridge University Press

- Pandit, Sudhakar M.; Wu, Shien-Ming (1983). Time Series and System Analysis with Applications. John Wiley & Sons

- Hamilton, James D. (1994), Time Series Analysis, Princeton University Press, ISBN 0691042896

![{\displaystyle \operatorname {E} (X_{t+n}|X_{t})=\mu \left[1-\left(1-\theta \right)^{n}\right]+X_{t}(1-\theta )^{n}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/75c5310d8f5ee2c2c70c83c9b3eaebab528f4f69)

![{\displaystyle \operatorname {Var} (X_{t+n}|X_{t})=\sigma ^{2}{\frac {\left[1-(1-\theta )^{2n}\right]}{1-(1-\theta )^{2}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/739a8440fec97db749f7444d6107b8d010649c1a)